Nuestra integración NVIDIA Triton monitorea la implementación y gestión del modelo de IA en el entorno de producción. Triton proporciona una solución flexible y escalable para implementar modelos de aprendizaje profundo, lo que permite a la organización implementar de manera eficiente la aplicación de IA en una variedad de plataformas de hardware, incluidas GPU y CPU.

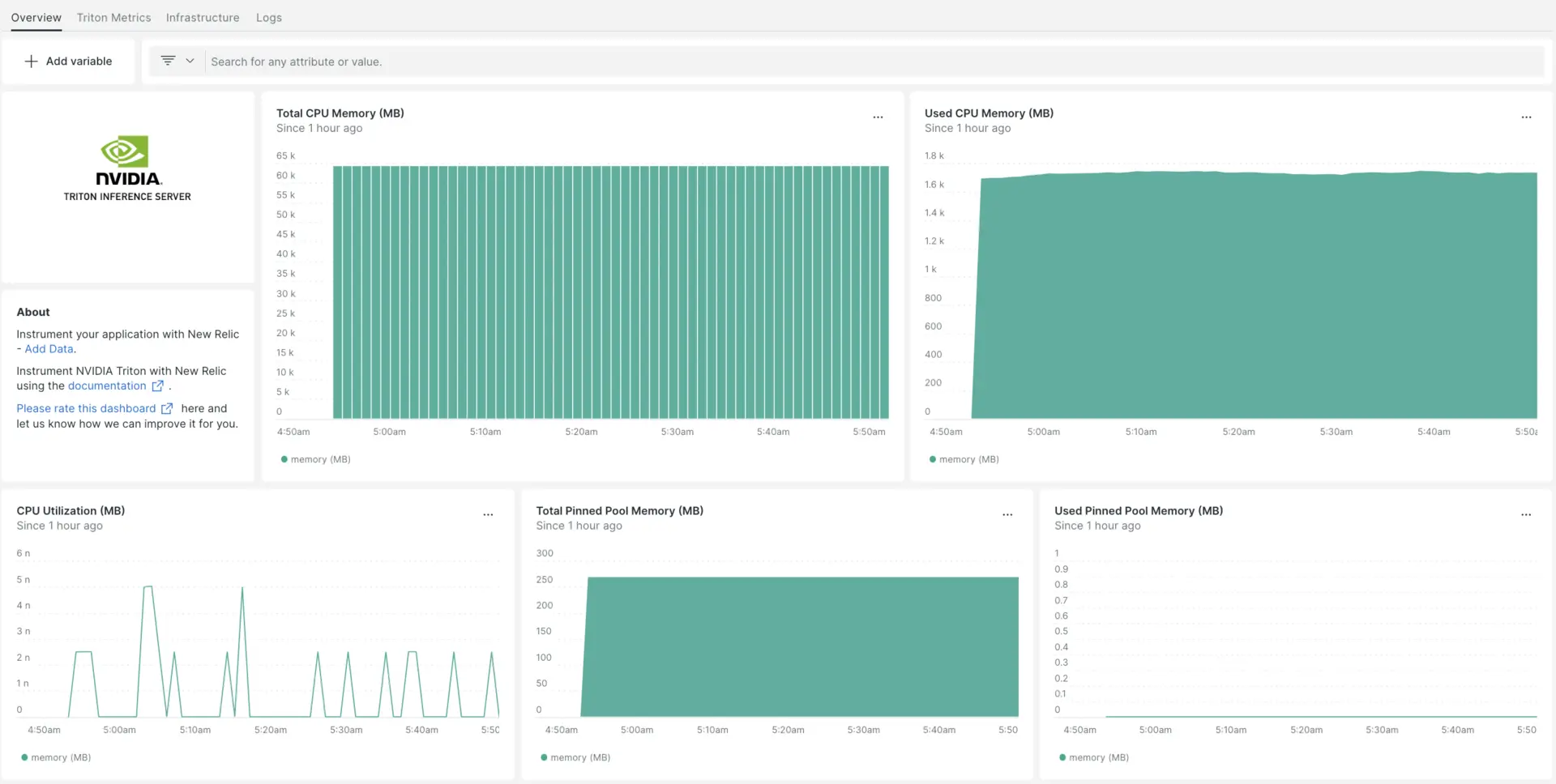

Luego de configurar nuestra integración NVIDIA Triton, te brindamos un dashboard para tu NVIDIA Triton métrica.

Instalar el agente de infraestructura

Para utilizar la integración de NVIDIA Triton, también debe instalar el agente de infraestructura en el mismo host. El agente de infraestructura monitorea el host en sí, mientras que la integración que instalará en el siguiente paso amplía su monitoreo con datos específicos de NVIDIA Triton.

Habilite la integración de NVIDIA Triton con nri-prometheus

Las métricas del servidor Triton se muestran en la URL http://localhost:8002/metrics.

Sugerencia

Para obtener detalles adicionales sobre cómo recopilar la métrica del servidor Triton, consulte la documentación de NVIDIA.

Para configurar la integración de NVIDIA Triton, siga estos pasos:

Ejecute este comando para crear un archivo llamado

nri-prometheus-config.ymlen el directorio de integración:bash$touch /etc/newrelic-infra/integrations.d/nri-prometheus-config.ymlAgregue el siguiente fragmento a su archivo

nri-prometheus-config.ymlpara permitir que el agente capture datos de NVIDIA Triton:integrations:- name: nri-prometheusconfig:# When standalone is set to false nri-prometheus requires an infrastructure agent to work and send data. Defaults to truestandalone: false# When running with infrastructure agent emitters will have to include infra-sdkemitters: infra-sdk# The name of your cluster. It's important to match other New Relic products to relate the data.cluster_name: "YOUR_DESIRED_CLUSTER_NAME"targets:- description: NVIDIA Triton metrics listurls: ["http://localhost:8002/metrics"]# tls_config:# ca_file_path: "/etc/etcd/etcd-client-ca.crt"# cert_file_path: "/etc/etcd/etcd-client.crt"# key_file_path: "/etc/etcd/etcd-client.key"# Whether the integration should run in verbose mode or not. Defaults to falseverbose: false# Whether the integration should run in audit mode or not. Defaults to false.# Audit mode logs the uncompressed data sent to New Relic. Use this to log all data sent.# It does not include verbose mode. This can lead to a high log volume, use with careaudit: false# The HTTP client timeout when fetching data from endpoints. Defaults to 30s.# scrape_timeout: "30s"# Length in time to distribute the scraping from the endpointsscrape_duration: "5s"# Number of worker threads used for scraping targets.# For large clusters with many (>400) endpoints, slowly increase until scrape# time falls between the desired `scrape_duration`.# Increasing this value too much will result in huge memory consumption if too# many metrics are being scraped.# Default: 4# worker_threads: 4# Whether the integration should skip TLS verification or not. Defaults to falseinsecure_skip_verify: truetimeout: 10s

Configuración de los logs de NVIDIA Triton

Para configurar los logs de nvidia triton, siga los pasos que se describen a continuación.

Ejecute este comando Docker para verificar el estado de ejecución del contenedor:

bash$sudo docker psCopie el ID del contenedor para el contenedor nvidia-triton y ejecute este comando:

bash$sudo docker logs -f <container_id> &> /tmp/triton.log &Luego, verifique que haya un archivo de log llamado

triton.logubicado en el directorio/tmp/.

Reenviando los logs de NVIDIA Triton a New Relic

Puede utilizar nuestro reenvío de logs para reenviar los logs de NVIDIA Triton a New Relic. En máquinas Linux, su archivo de log llamado logging.yml debe estar en esta ruta:

$cd /etc/newrelic-infra/logging.d/Una vez que encuentre el archivo de log en la ruta anterior, incluya este script en el archivo logging.yml:

logs: - name: triton.log file: /tmp/triton.log attributes: logtype: triton_logsReinicie el agente New Relic Infrastructure

Ejecute este comando para reiniciar su agente de infraestructura:

$sudo systemctl restart newrelic-infra.serviceEn un par de minutos, tu servidor NVIDIA Triton enviará métricas a one.newrelic.com.

Encuentra tus datos

Puede elegir nuestra plantilla dashboard prediseñadas llamada NVIDIA Triton para monitor su servidor NVIDIA Triton métrica. Siga estos pasos para utilizar nuestra plantilla dashboard prediseñadas:

Vaya a one.newrelic.com > Integrations & Agents y escriba NVIDIA Triton.

En Dashboards, haga clic en NVIDIA Triton.

Haga clic en Edit si desea cambiar la cuenta en la ventana emergente abierta.

Haga clic en Setup NVIDIA Triton u Skip this step si ya configuró esta fuente de datos.

Haga clic en View dashboard y vea sus datos de NVIDIA Triton en New Relic.

Puedes encontrar tu dashboard personalizado de NVIDIA Triton en la UI Dashboards. Consulte nuestra sección dashboard para obtener más información.

Aquí hay una consulta NRQL para verificar la memoria de la CPU NVIDIA Triton:

SELECT latest(nv_cpu_memory_total_bytes) / 1e+6 AS 'memory (MB)' FROM Metric

¿Que sigue?

Para obtener más información sobre cómo crear una consulta NRQL y generar un panel, consulte estos documentos:

- Introducción al generador de consultas para crear consultas básicas y avanzadas.

- Introducción al panel para personalizar tu dashboard y realizar diferentes acciones.

- Administre su dashboard para ajustar kkukk el modo de visualización de su panel o para agregar más contenido a su dashboard.